惊人的天赋与无人察觉的缺陷并存,GPT-3的未来有

今年夏天,美国旧金山的一个人工智能(AI)实验室推出了一个新的计算机系统,这个新系统名为 GPT-3,而这个实验室就是人人皆知的 OpenAI。在随后的几个月时间里,该系统详细学习了自然语言的细节之处,这些学习内容来源于数以千计的电子书籍、维基百科以及写在博客、社交媒体和互联网上的近万亿字。

Mckay Wrigley 是美国盐湖城(Salt Lake City)的一名 23 岁的电脑程序员,同时他也是少数受邀修补 GPT-3 系统的人之一。他想知道这个系统能否模仿公众人物,比如像他们一样写作,甚至可以像他们一样聊天。

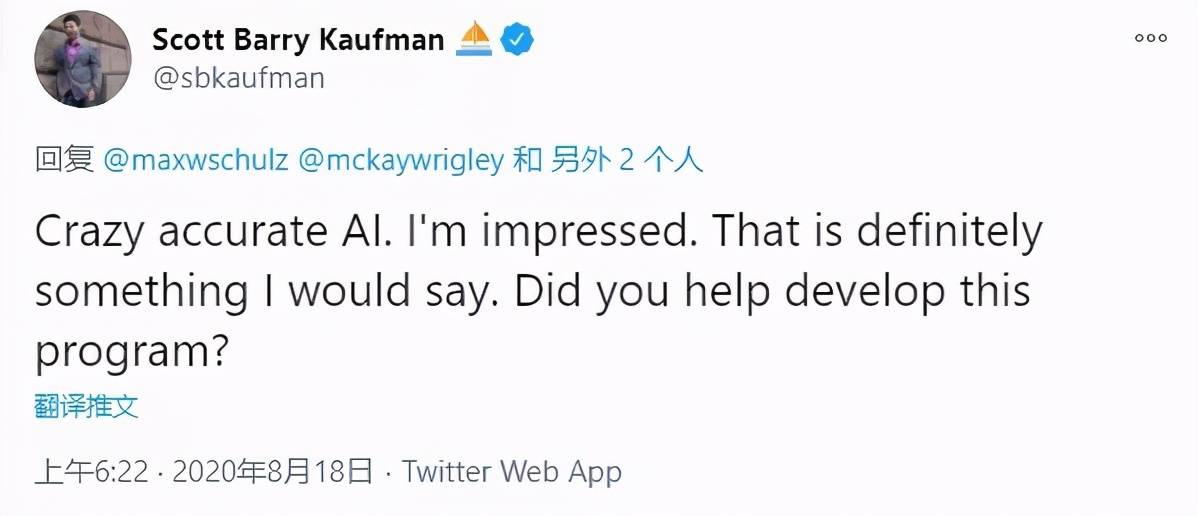

他的一项实验涉及一位流行心理学家 Scott Barry Kaufman。GPT-3以 Kaufman 的名字命名并且讨论了关于创造力的话题。当被问到“我们如何才能变得更有创造力?”时,GPT-3 立刻回应道:

我认为创造性表达是在一个多元化世界中成长的必需品。世界越多样化,你接触到不同的人、不同的机会、不同的地方和不同的挑战就越多样化,你就越有可能把这些点组合在一起从而形成一些新的东西。在许多方面,我认为如果你想有创造力,你必须去做。如果你想成为一名作家,你必须写作,如果你想成为一名音乐家,你必须创造音乐,如果你想成为一名喜剧演员,你必须创造喜剧,你创造的越多,你就越有可能在这些创造的过程中偶然发现一些有趣的事情。

(I think creative expression is a natural byproduct of growing up in a diverse world. The more diverse the world is, the more you get exposed to different people, to different opportunities, to different places and to different challenges. And the more diverse that is, the more likely you’ll be to be able to put the dots together to form something new. And in many ways, I think if you want to be creative, you have to go for it. If you want to be a writer, you have to write, if you want to be a musician, you have to create music, if you want to be a comedian, you have to create comedy, and the more you create, the more likely it is that you’ll stumble onto some interesting stuff.)

后来,当 Wrigley 把这段话发表在 Twitter 上时,有人@了真正的 Scott Barry Kaufman。Kaufmanbe 本人看完后惊呆了:“这听上去就像是我要说的话,疯狂而又准确的 AI!”

(来源:Twitter)

在 GPT-3 发布的几周内,又接连进行了数十项其他实验,这些实验也以同样的方式引起了人们的注意。它生成推文、写诗、总结电子邮件、回答琐碎问题、翻译语言,甚至可以编写计算机程序,在这一过程中,GPT-3 只需要获得很少的提示就能完成这些任务,其中一些技能甚至让专家们都措手不及。

对于许多 AI 研究人员来说,这是朝着能够理解变幻莫测语言的机器迈出了意想不到的一步,它甚至可能用来理解人类的其他技能。

墨西哥圣达菲研究所(the Santa Fe Institute)的 AI 研究员、GPT-3 的实验者之一 Melanie Mitchell 表示:“这让我和很多人都感到惊讶,很难弄清楚这东西到底在干什么。”

但是,GPT-3 并非完美无瑕。它经常吐露一些有偏见且恶毒的语言。如果你要 10 段 Scott Barry Kaufman 风格的话语,那它可能会给你 5 段令人信服的话,另外 5 段则不是如此。当 Kaufman 真正和 AI("Scott Barry Kaufman") 聊天时,并没有像一开始那样印象深刻:

Scott Barry Kaufman:什么是想象力?

"Scott Barry Kaufman":什么是想象力?你应该告诉我!

Scott Barry Kaufman:你应该知道!

"Scott Barry Kaufman":不,你应该知道!你就是那个知道什么是想象力的人。你觉得想象力是什么?

这看起来像是真正的谈话。此外,值得注意的是,它也展示了系统可以独立地完成工作,而无需额外编程或调整的能力。

GPT-3 是世界领先的 AI 实验室通过多年科研工作取得的最终成果,这些实验室包括由微软耗资 10 亿美元资助的独立组织 OpenAI,以及谷歌和 Facebook 的实验室。在谷歌,也有一个类似的系统可以帮助回答公司搜索引擎上的查询结果。

这些被称为通用语言模型的系统可以帮助开发各种各样的工具,比如自动总结新闻文章的 “服务机器人” 和为在线对话设计的 “聊天机器人”。到目前为止,它们对现实世界技术的影响很小。但是,GPT-3 为一系列新的可能性打开了大门,比如可以加速新智能手机应用程序开发速度的软件,或者实现更加人性化交谈的聊天机器人。

随着越来越多软件设计师、企业家、专家学者和艺术家开始探索这个系统,每一项新的实验都可能引发一场关于这种技术最终将有多强大的激烈辩论。虽然有人说这可能是通向真正智能机器的道路,但另一些人则认为这些实验虽然令人着迷,同时也存在一定的误导性。

对此,佐治亚理工学院教授研究员 Mark Riedl 说:“它非常流利,它能言善辩,它非常擅长制作听起来合理的文本。然而,它没有做的是提前思考。它没有计划要说什么。它并没有真正的目标。”

一种“新生性”Jordan Singer 是硅谷移动支付公司 Square 的产品设计师。他帮助设计了该公司的智能手机应用程序、构建图形、菜单、按钮和其他定义应用程序外观和内容的小部件。当他听说 GPT-3 时,他想知道这个自动化系统能否完成他的工作。

他向系统输入了一个智能手机应用程序的简单描述,以及创建该应用程序所需的计算机代码,代码描述使用的是简单的英语。该代码是在 Figma 内部构建的,Figma 是像 Singer 这样的专业人士使用的一种专门设计工具。

他这样做了几次,在匹配 Figma 代码的同时,也给系统提供了更多的英语描述。当他完成这些操作后,他发现 GPT-3 可以独立地编写这样的代码。

如果他像用户在 Instagram 上那样描述一个简单的发布和查看照片的应用程序,系统就会生成构建它所需的代码。这段代码有时有缺陷,但在通常情况下,如果 Singer 只是做了一两个小调整,就会如他所愿。“这不是绝对完美的,但是已经离我想要的应用程序非常近了。”

这种行为是全新的,甚至让 GPT-3 的设计者也感到惊讶。他们最初创造 GPT-3 的目的并不是为了编写计算机代码,就像没有设计它像 Kaufman 那样写作,或者生成推文和翻译语言一样。他们建造它只是为了做一件事情:用一系列单词来预测下一个单词(predict the next word in a sequence of words)。

GPT-3 是 AI 研究人员所谓的神经网络,一个松散地模仿大脑神经元网络的数学系统。这项技术可以识别你发布到脸书照片中的人脸,并识别你向手机发出的命令。

神经网络通过精确定位大量数字数据中的固定模式来学习这些技能。比如,通过分析数千张猫的照片,它可以学会识别一只猫。

(来源:Pixabay)

大约三年前,谷歌和 OpenAI 等顶级实验室的研究人员开始设计神经网络,这些神经网络从大量散文中学习,包括数千人未出版的书籍和维基百科文章。这些通用语言模型不仅可以应用于一项翻译任务,还可以应用在许多任务上。

GPT-3 以前所未有的规模分析数字散文,花费数月时间在发布到互联网的大量文本中寻找固定模式。就这样,它学会了预测一个序列中的下一个单词。如果你在 GPT-3 中输入几个单词,它会继续下去,用整段文本完成你想要的散文。

但在获得这种特定技能的过程中,它学到了更多。在几个月的训练中,GPT-3 在书籍、维基百科文章和其他在线文本的海洋中识别了超过 1750 亿个参数,这些参数都可以由固定模式的数学表示。这些模式相当于人类语言的地图:对我们将字符组合在一起的方式的数学描述。无论我们写博客还是对软件程序编程,使用这张地图,GPT-3 可以执行各种各样的任务,而这可能并不是它最初的本意。

在要求 GPT-3 生成新的文本之前,你可以将注意力集中在它可能在训练中学习到的特定模式上,从而为系统的某些任务做准备。你可以给它输入智能手机应用程序的描述和匹配的 Figma 代码。或者你可以展示大量的人类对话。然后,当你开始打字时,它将以更具体的方式完成序列(complete the sequence)。比如,如果你用对话引导它,它就会开始和你聊天。

对此,OpenAI 研究副总裁 Dario Amodei 表示:“它具有这种新生性(emergent quality)。它有能力识别人们给出的模式,并继续完成故事,同时还会再举一个例子。”

尽管以前的语言模型也以类似的方式工作。但是 GPT-3 可以执行以前模型做不到的事情,比如编写自己的计算机代码。更重要的是,你可以用几个例子为特定的任务做准备,而不是像它的 “前辈们” 那样需要成成年上万的例子和数小时的额外训练。研究人员称之为“少样本学习”(few-shot learning),他们相信 GPT-3 在这一领域为人类提供了第一个真实案例。

OpenAI 首席科学家、过去十年中 AI 领域的关键人物 Ilya Sutskever 表示:“它展示了一种没人认为能够实现的能力。任何外行人都可以利用这个模型,在大约 5 分钟内提供这些例子,并从中获得有用的行为。”

这既是福,也是祸。

它安全吗?OpenAI 计划通过互联网销售 GPT-3 的访问权限,使其成为一种广泛使用的商业产品,今年它使有限数量的测试人员可以通过他们的网络浏览器使用该系统。不久之后,领导 Facebook AI 实验室的 Jerome Pesenti 称 GPT-3 并 “不安全”,指出当被要求讨论妇女、黑人、犹太人和大屠杀时,该系统会产生性别歧视、种族主义和其他有害的语言。

对于 GPT-3 这样的系统,这个问题是普遍存在的,因为日常语言本身就是有偏见的,而且有时往往令人讨厌,尤其是在互联网上。因为 GPT-3 从这种语言中学习,它也可以表现出偏见和仇恨。从互联网文本中学习,可以将无神论与“酷”和“正确”两个词关联起来,也可以将伊斯兰教与“恐怖主义”配对。

这可能是 OpenAI 只与少量测试人员共享 GPT-3 的一个原因。实验室已经建立了过滤器(filters),警告有害语言可能即将来临,但它们只是放置在一个没有人知道如何解决的问题上的 “创可贴”。

斯坦福大学研究员 Allison Koenecke 表示:“他们不仅公开发布 GPT-3,而且也在做许多正确的事情。但目前仍有许多事情悬而未决。”

帮助企业管理 AI 技术行为的 Arthur 公司副总裁 Liz O’Sullivan 认为,OpenAI 最终有责任确保这种行为得到控制。就目前情况而言,OpenAI 正在 “将法律和声誉风险转嫁给任何想要在面向消费者的应用程序中使用该模型的人”。

也有其他专家担心,这些语言模式可能还会帮助在互联网上传播虚假信息,误导可能有助于影响类似于 2016 年总统选举的在线竞选。GPT-3 指向了一个未来:我们更不确定我们所读的东西是真是假。这适用于推文、在线对话、甚至长篇散文。

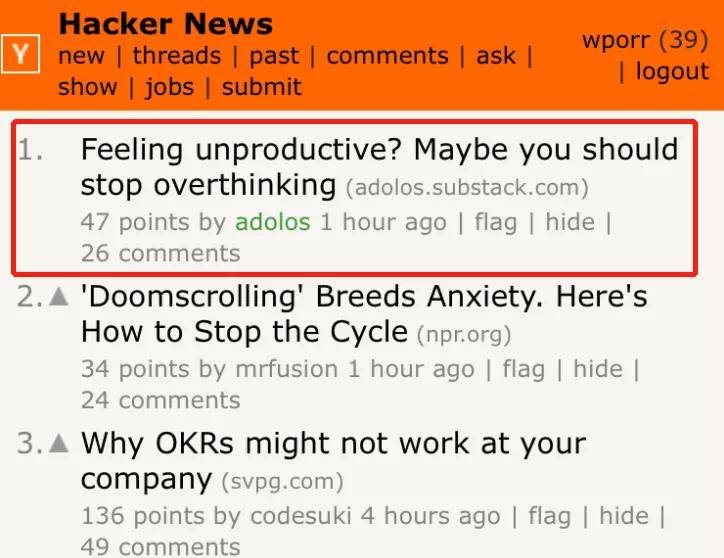

今年 7 月底,加州大学伯克利分校的学生 Liam Porr 用 GPT-3 生成了几篇博客文章,并将它们发布在了互联网上,竟有 26000 人阅读(Feeling unproductive? Maybe you should stop overthinking),60 名观众阅读后订阅了博客,只有少数人怀疑这些帖子是由一台机器写的。

他们不一定是容易受骗的人。其中一篇博文认为,如果你不对每件事都想太多,你可以提高你的工作效率。“为了做成一件事,也许我们需要少思考,” 帖子开始写道,“这似乎违反直觉,但我相信有时我们的想法会妨碍创作过程。” 这篇博文在 Hacker News 上冲上了第一位。Hacker News 是硅谷经验丰富的程序员、工程师和企业家对新闻文章和其他在线内容进行评级的网站。

(来源:Liam Porr)

但与大多数涉及 GPT-3 的实验一样,Porr 的实验并不像看起来那么强大。

无人察觉的缺陷20 世纪 60 年代中期,麻省理工学院的研究员 Joseph Weizenbaum 建立了一个自动化的心理治疗师,并将其称之为 ELIZA。从目前互联网的发展现状来看,这个聊天机器人非常简单。

与 GPT-3 不同,ELIZA 没有从散文中学习。它按照设计师定义的一些基本规则运行。它几乎重复了你对它说的任何话,只是以问句的形式。但令 Weizenbaum 惊讶的是,许多人把机器人当作人一样对待,毫无保留地回应他们的问题,并在回应中获得安慰。

当狗和其他动物表现出少量类似人类的行为时,我们往往认为他们在模仿我们,而不是它们真正的行为。研究动物和机器的认知技能的匹兹堡大学教授 ColinA allen 表示,机器也是一样,“人们被‘吸’进去了,即使他们知道他们被‘吸’进去了。”

这是 GPT-3 的一部分。因为它可以生成令人信服的推文、博客文章和计算机代码,因此我们会阅读到这个数字系统中,并且较少关注其局限性。

实际上,系统故障与成功的次数差不多。我们忽略了它编写的计算机代码需要人类程序员进行一些微调——在这里删除一行,在那里添加一行。我们没有注意到,在几次交流之后,它的对话天赋就会失效,因为它无法 “记住” 几秒前说的话。我们也没有完全意识到,虽然这个系统为 Porr 先生写了一篇令人信服的博文,但他提供了标题和照片以及前几句话,并删除了一些不太有说服力的句子。

Porr 先生不相信 GPT-3 在短期内对打击虚假信息的战斗构成巨大威胁,因为它仍然需要人类的大量帮助。这样的工具只有在能够完全自己产生大量令人信服的虚假信息时,才会变得真正危险,这超过了一个雇佣团队今天相对容易做到的程度。

同样,当应用程序设计师问 Singer 关于 GPT-3 是否对其职业生涯构成威胁时,他向他们保证,至少现在还没有。他认为这是让他们的工作更轻松的一种方式。他说:“如果能达到 70%,那将意味着许多繁琐的工作将会消失。”

我们不知道的是,这项技术在未来几个月和几年里会有多少改进。

更智能、更快、也更贵当 OpenAI 的研究人员正在对 GPT-3 进行超过 1 万亿字的网络培训时,他们进行了第二次实验,对数万张数码照片进行了类似的系统培训。该系统可以分析所有这些照片,并学习构建图像,就像 GPT 3 构建段落一样。给定一张猫的照片的一半,它可以生成猫的其余部分。

对于一些研究人员来说,这个实验表明,这样的系统最终可以像人类一样,同时处理语言、视觉、声音等跨越多个维度的任务。他们说,即使仅仅接受语言训练,这个系统也能用于其他领域,无论是计算机编程、下棋还是制作吉他标签。

但是,继续改进这项技术并不是一件小事。处理所有这些互联网数据需要一台专门的超级计算机并连续运行数月,这是一项极其昂贵的工作。当被问及这样的项目是否涉及数百万美元时,OpenAI 首席执行官 SamAltman 表示,成本实际上“更高”,可能会达到达数千万美元。

对此,OpenAI 负责研究的副总裁 Amodei 表示,这项技术仍有改进的空间,可以使用更多的处理能力来分析更多的数据。但他也表示,这种方法可能快没 “果汁” 了(running out of “juice”)。

但至少,GPT-3 对 AI 研究人员和企业家来说是一个新的工具,一种建立各种新技术和新产品的方式。计算机程序员 Wrigley 最近辞去了日常工作,开始成立一家名为 “学习任何人”(LearnFromAnyone)的公司,该公司的目标是利用 GPT-3 构建一种自动化导师,这种导师可以伪装成从科学家 Douglas Hofstadter 到风险资本家 Peter Thiel 的所有人。另一些公司正在建立其他的一些初创企业,计算机程序员自动生成代码,并为营销专业人员自动编写促销电子邮件和推文。

但目前还不清楚这些服务最终会多么富有成效。如果 GPT-3 只有一半的时间产生正确的文本,它能让专业人士满意吗?目前还不清楚这项技术是否是真正的对话机器,更不用说真正的智能系统了。Amodei 表示,在通往能够模仿人类大脑的漫长道路上如果想要取得更多进展,需要全新的想法。

“这有点像化学反应,我们有这一种成分。但也需要其他成分。” Amodei 说。

翻译:阳光

原文链接:

https://www.nytimes.com/2020/11/24/science/artificial-intelligence-ai-gpt3.html

责任编辑: